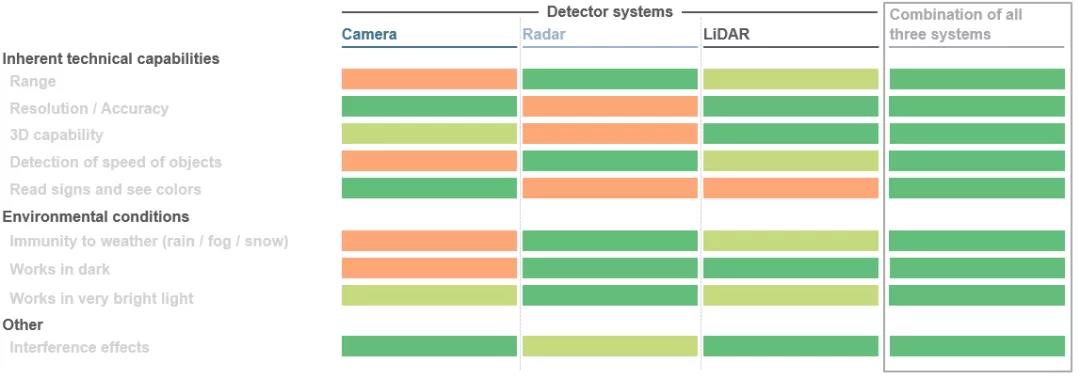

Dokonuje się ogromny skok w mobilności. Dotyczy to zarówno sektora motoryzacyjnego, w którym opracowywane są rozwiązania w zakresie autonomicznej jazdy, jak i zastosowań przemysłowych z wykorzystaniem robotyki i zautomatyzowanych pojazdów sterowanych. Poszczególne elementy w całym systemie muszą ze sobą współpracować i uzupełniać się. Głównym celem jest stworzenie jednolitego widoku 3D wokół pojazdu, wykorzystanie tego obrazu do obliczenia odległości obiektów i zainicjowanie kolejnego ruchu pojazdu za pomocą specjalnych algorytmów. W rzeczywistości stosowane są tutaj jednocześnie trzy technologie czujników: LiDAR (LiDAR), radar i kamery. W zależności od konkretnego scenariusza zastosowania te trzy czujniki mają swoje zalety. Połączenie tych zalet z nadmiarowymi danymi może znacznie poprawić bezpieczeństwo. Im lepiej te aspekty są skoordynowane, tym lepiej autonomiczny samochód będzie w stanie poruszać się w swoim otoczeniu.

1. Bezpośredni czas lotu (dToF):

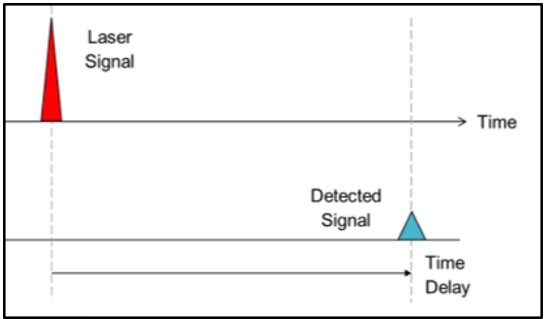

W podejściu opartym na czasie lotu producenci systemów wykorzystują prędkość światła do generowania informacji o głębokości. Krótko mówiąc, skierowane impulsy świetlne są wystrzeliwane w otoczenie, a gdy impuls świetlny uderza w obiekt, jest odbijany i rejestrowany przez detektor w pobliżu źródła światła. Mierząc czas potrzebny na dotarcie wiązki do obiektu i powrót, można określić odległość obiektu, podczas gdy w metodzie dToF można określić odległość pojedynczego piksela. Odebrane sygnały są ostatecznie przetwarzane w celu uruchomienia odpowiednich działań, takich jak manewry omijania pojazdów w celu uniknięcia kolizji z pieszymi lub przeszkodami. Ta metoda jest nazywana bezpośrednim czasem przelotu (dToF), ponieważ jest związana z dokładnym „czasem przelotu” wiązki. Typowym przykładem zastosowań dToF są systemy LiDAR dla pojazdów autonomicznych.

2. Pośredni czas lotu (iToF):

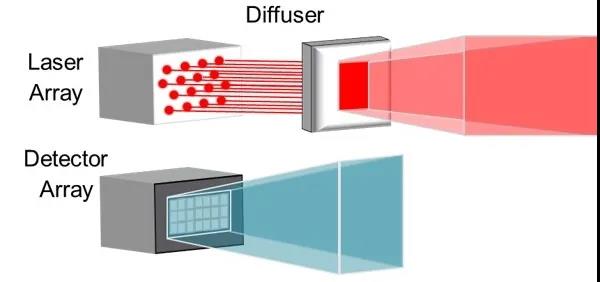

Podejście pośredniego czasu lotu (iToF) jest podobne, ale z jedną zauważalną różnicą. Oświetlenie ze źródła światła (zwykle VCSEL na podczerwień) jest wzmacniane przez arkusz unikający, a impulsy (50% cyklu pracy) są emitowane w określonym polu widzenia.

W dalszym systemie zapisany „sygnał standardowy” uruchomi detektor na pewien czas, jeśli światło nie napotka przeszkody. Jeśli obiekt przerywa ten standardowy sygnał, system może określić informacje o głębokości każdego zdefiniowanego piksela detektora na podstawie wynikowego przesunięcia fazowego i opóźnienia czasowego ciągu impulsów.

3. Aktywne widzenie stereo (ASV)

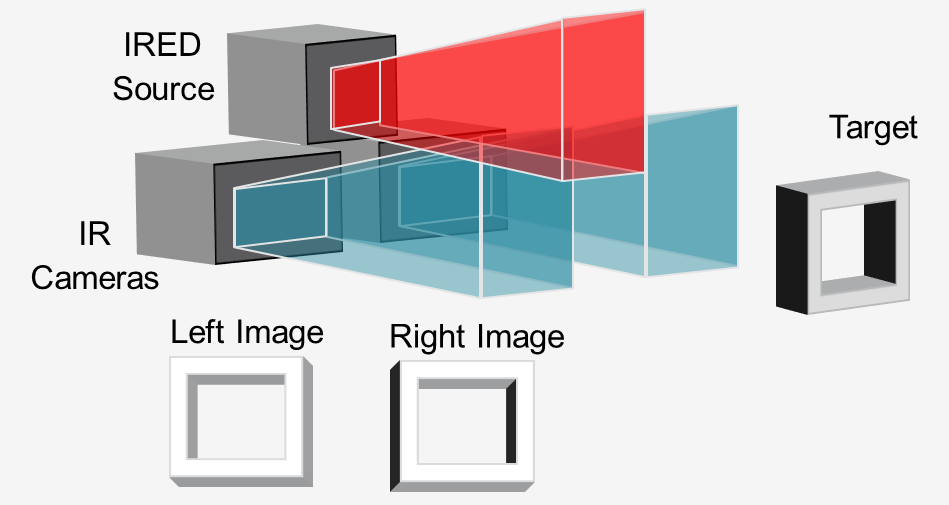

W metodzie „aktywnego widzenia stereoskopowego” źródło światła podczerwonego (zwykle VCSEL lub IRED) oświetla scenę wzorem, a dwie kamery termowizyjne rejestrują obraz w stereo.

Porównując oba obrazy, dalsze oprogramowanie może obliczyć wymagane informacje o głębokości. Światła obsługują obliczenia głębokości poprzez rzutowanie wzoru, nawet na obiekty o niewielkiej teksturze, takie jak ściany, podłogi i stoły. Podejście to jest idealne do wykrywania 3D z bliskiej odległości w wysokiej rozdzielczości w robotach i pojazdach sterowanych automatycznie (AGV) w celu unikania przeszkód.

Copyright @ 2020 Shenzhen Box Optronics Technology Co., Ltd. - Moduły światłowodowe China, producenci laserów sprzężonych z włóknami, dostawcy komponentów laserowych Wszelkie prawa zastrzeżone.